content

1. shell 기본 사용법

2. 명령어 사용 실습

3. 대상 데이터 수집 실습(css, xpath)

4. Fetch, View, response, request

shell 기본 사용법

shell이란? 스파이더를 실행하지 않고도 스크래핑 코드를 빠르게 시도하고 디버깅 할 수 있다. 데이터 추출 코드를 테스트 하는 데 사용하지만, 일반 python 셸이므로 모든 종류의 코드를 테스트 가능하다.

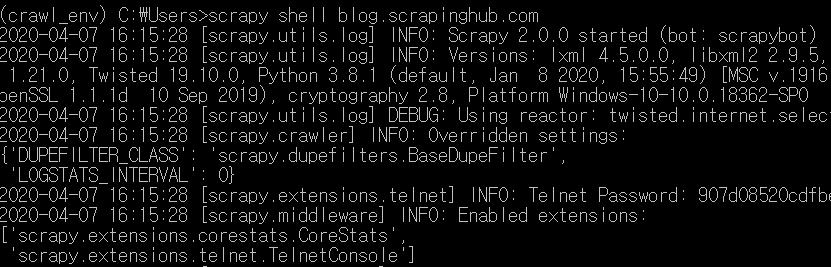

(1) 방법1

cmd : scrapy shell

cmd : fetch('https://blog.scrapinghub.com')

cmd : response

(2) 방법2

cmd : scrapy shell url

(3) 방법3

shell은 로컬 파일에서도 동작 가능하다.

cmd : scrapy shell (file path)

명령어

fetch(url) : 해당 url에 응답을 가져오고 관련 객체를 업데이트한다.

view(response) : 로컬 웹 브라우저를 연다.

사이트가 robots.txt가 허용되어 있지 않으면 shell이 실행되지 않는다.

해당 명령어로 setting 할 수 있다.

cmd : scrapy shell url --set=ROBOTSTXT_OBEY=False'

실습1

해당 url(https://blog.scrapinghub.com) 에서 section03 에서 했던 css를 shell을 실행시켜 추출해보자.

실습2

shell을 사용하여 https://comic.naver.com/webtoon/weekday.nhn 의 웹툰 제목을 추출해보자.

'Scrapy' 카테고리의 다른 글

| [Scrapy] 07. Selectors(css, xpath) (0) | 2020.04.08 |

|---|---|

| [Scrapy] 06. Scrapy Spider 활용 (0) | 2020.04.08 |

| [Scrapy] 04. Spider 활용 (0) | 2020.04.01 |

| [Scrapy] 03. Following links (1) | 2020.04.01 |

| [Scrapy] 02. 데이터 추출 (get vs extract) (0) | 2020.04.01 |

댓글